정의

- 심층 신경망으로 구현된 크기가 매우 큰 AI로 인공신경망의 파라미터(매개변수)가 무수히 많은 인공지능 모델

- 대용량의 연산이 가능한 컴퓨팅 인프라를 기반으로 대규모 용량의 데이터를 학습해 특정 용도에 한정하지 않고 종합적이고 자율적으로 사고, 학습, 판단, 행동하는 인간의 뇌 구조를 닮은AI(인공지능)

키워드

- 대규모 파라미터, 사전학습, 파인튜닝

메커니즘

기술요소

1980~1990 - 통계기반언어모델 - 최초의 언어모델 출현

2017 - 트랜스포머 알고리즘 - Attention 기반 트랜스포머 알고리즘의 출현

2018 - BERT 모델 - 트랜스포머의 인코더를 활용한 BERT 모델 출현

2018 - GPT 모델 - 트랜스포머의 디코더를 활용한 GPT 모델 출현

2020~2021 - GPT-3, LaMDA - 초거대 AI의 출현 (GPT-3, LaMDA 등)

2022- ChatGPT, GPT-4, Bard, PaLM, MT NLG- 초거대 AI의 발전 (ChatGPT, GPT-4, Bard, PaLM, MT NLG)

※ 파라미터 규모가 증가할수록 언어모델 서비스가 고도화되며, 인간에 의한 피드백과 강화학습(GPT-3.5의 RLHF1))을 통하여 언어모델을 학습시키면 더 적은 파라미터 규모로 보다 높은 성능을 달성 가능.

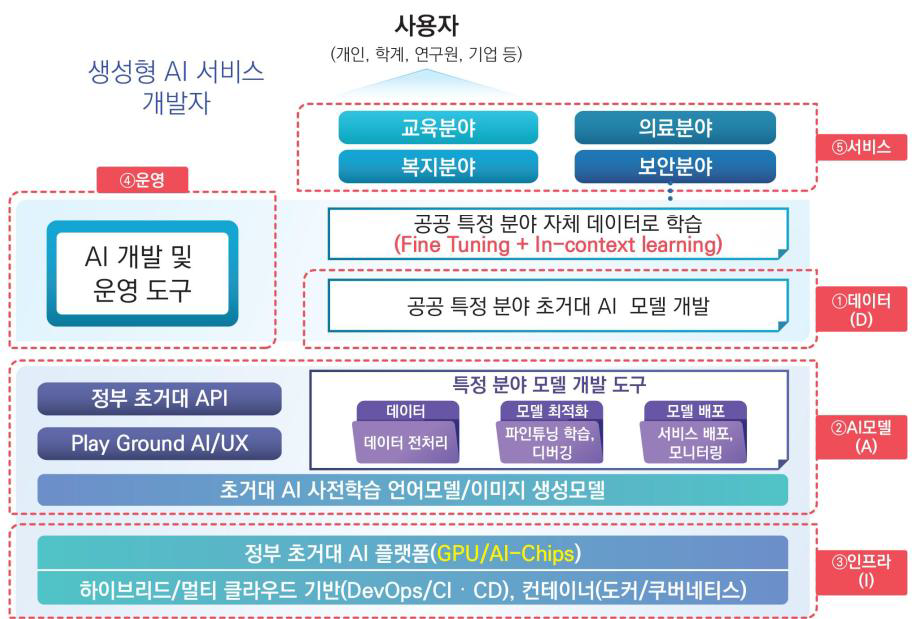

※ 정부 초거대 AI 인프라/플랫폼을 기반으로 정부부처별로 조정(Adaptation)을 적용하여 공공성과 도메인전문성이 결합된 AI 서비스를 제공

AI 모델

AI 모델 선정

- ChatGPT의 상세 내용이 공개되지 않았으므로 ChatGPT replica를 이용하여 초거대 AI 모델을 구축

- InstructGPT의 Step 1, Step 2, Step 3가 모두 구현된 공개소스를 활용

사전 학습된 모델

- 사전 학습된 모델 중 공개된 비상업 모델의 활용가능성 검토(OPT-175B 등)

- 사전 학습된 모델 중 온프레미스 방식으로 획득가능한 모델 검토(MS의 정책 확인, 네이버의 하이퍼클로바 가능성 확인, 카카오브레인의 KoGPT 가능성 확인 등)

도메인별 조정(DomainAdaptation)

- 공공의 목적에 맞는 학습데이터 (일반 텍스트)로 학습을 한번 더 진행

(과학기술 데이터, 국가 행정문서, 예산, 법무 매뉴얼 등)

SFT학습(Supervised Fine-Tuning)

- 추가 사전 학습된 모델에 SFT목적으로 제작된 각 도메인의 학습데이터를 이용해 Supervised Learning 진행

RLHF(Reinforcement Learning with Human Feedback)

- 추가 사전학습한 모델에 SFT학습을 추가하고, 해당 모델에 대하여 InstructGPT 절차에 따른 RLHF 학습 수행

- 각 도메인 별 RM, SFT에서 제작한 학습 데이터를 이용해 PPO 기반의 학습 진행(부처별 데이터에 대해 특화된 모델 구현)

인프라

인프라 구축

- 정부부처, 지자체, 공공기관의 데이터 보안을 유지하고, 학습에 따라 변동되는 리소스 자원을 효율적으로 관리하기 위하여 공공 클라우드 내 필요한 자원을 확보

자원확보 방안

- GPU 개수와 기본모델 학습시간, 미세조정 학습 시간 등을 고려하여 GPU의 단계적 지속적 도입

- 공공 데이터의 단계적 수집/정제/가공을 고려하여 메모리 및 저장 장치 확보

데이터

원천 데이터 수집전략

- 초거대 AI를 구축하기 위하여 필요한 데이터 중 기본 데이터는공개된 자료를 확보하여 재활용

- 국민생활에 밀접하게 관련이 있고 효과가 가장 큰 분야 선정

- 필터링 데이터를 생성하기 위한 분류체계를 수립하고 이에 대한응답 데이터를 수작업으로 생성

- 공공데이터포털, 국립중앙도서관, AI Hub, 국가기록원 데이터 수집 활용

학습데이터 제작 방안

- ChatGPT 기반의 공공 모델을 구축하기 위해서는 각 도메인(교육,복지, 의료 등) 별 SFT, RM을 위한 총 2가지 학습 데이터를 구축

- SFT 데이터 생성 : 공공분야의 도메인 별 지도학습을 위한 질의-응답 구조의 프롬프트 데이터셋 생성. 기본적으로 직접 생성이나 데이터가 있을 경우 ‘Prompt Engineering’을 이용해 자동생성 가능

- RM 데이터 생성 : 공공분야 도메인별 질의-다수응답-정답 구조의 프롬프트 데이터셋 생성할 때, 하나의 프롬프트에 대한 다수응답은 GPT4, ChatGPT등을 이용해 구축 가능하며 다수응답 중 제일 우수한 응답은 실제 사람이 직접 선택

- 각 도메인별 1만건 이상의 SFT, RM 학습 데이터를 초기 학습데이터로 만들어 총 5만건 이상의 학습데이터 구축 이후 데이터 증강 혹은 ‘Prompt Engineering’을 이용해 학습 데이터 확장

데이터 유형

- GPT-4 replica 공개 전까지 텍스트 데이터 위주로 데이터 수집·정제·가공하고 멀티모달 데이터를 즉시 학습에 도입할 수 있도록 수집/정제/가공 체계를 수립하여 일부 데이터를 학습에 활용

- 데이터 정제 - 공공데이터로서 공통적인 민감정보 정제 및 부처별 민감정보 정의

- 학습 데이터셋에 포함되기 위하여 기본적인 정제를 수행(비식별화, 개인정보 보호 등)

운영

학습

- 초거대 AI를 학습시키기 위한 전문인력 확보 및 관련 교육 전파

- InstructGPT기반 학습 단계 숙지 및 수행(SFT 학습, RM 학습 후, 강화학습 실시, 각 학습을 언제 중단하고 다음 단계로 이동할 것인지 기준 설정 필요)

- 실시간 학습은 지양

- Few-shot 러닝을 지향

추론 및 배포

- 추론 성능에 따라 자체 테스트 후 배포

- 배포된 모델의 버전관리

- 추가학습 - 추가학습 데이터를 확보하기 위하여 사용자에게 답변에 대한 평가를 유도

- 평가는 환각(잘못된 답변), 유해정보, 편향정보, 답변 회피 등으로 구분

- 사용자 평가데이터의 통계 정보를 지속적으로 모니터링, 일정 수치를 넘으면 추가학습 실시(또는 주기적으로 실시)

서비스

기본 서비스

- 프롬프트에 따라 요약, 대화, 코드생성, 인터뷰 질문 생성 제공

분야별 서비스

- 국가 초거대 AI기반 공공분야별 최적화된 언어모델 서비스

- 공공분야가 아닌 경우 가능한 답변을 회피

참고

- 초거대AI(언어·이미지 이해·생성능력)를 기반으로 전문분야 지식을 학습시켜 수요자가 효과적으로 활용 가능한

전문서비스를 제공

'Professional Engineer > AI' 카테고리의 다른 글

| 인공지능, 기계학습 적대적 공격 (0) | 2024.09.21 |

|---|---|

| 파괴적 망각(Catastrophic Forgetting) (0) | 2024.09.21 |

| 프롬프트 엔지니어링(Prompt engineering) (0) | 2024.09.20 |

| 그리드서치와 랜덤서치 (0) | 2024.09.20 |

| Zero-shot, One-shot, Few-shot Learning (0) | 2024.09.20 |

댓글